Inteligencia Artificial

Deep Learning: El campo que Impulsa la IA

30 de abril de 2025 · 9 min lectura

🤖 La inteligencia artificial (IA), como bien sabemos, está en todas partes. Desde las recomendaciones de Netflix 🎬, anuncios en prácticamente todas las redes sociales que utilizamos 📱, modelos de lenguaje en nuestras aplicaciones de mensajería 💬, hasta los asistentes virtuales como Alexa y Google Assistant 🗣️. De cualquier modo, la IA ha cambiado la forma en que interactuamos con la tecnología, ya que siempre se presenta en nuestras vidas de manera cotidiana de forma directa o indirecta. Pero, ¿qué hace que estas máquinas sean tan "inteligentes"? 🤔 La respuesta corta está en el Deep Learning o Aprendizaje Profundo 🧠.

¿Y qué se supone que es el Deep Learning?

Robot pensando

🤔 Bueno, más que ser algo, es un campo de estudio en constante desarrollo que surgió en 1957 (bastante adelantado para la época, ¿no crees?). El Deep Learning es un tipo de aprendizaje automático inspirado en la arquitectura y funcionamiento del cerebro humano 🧠.

Para intentar representar el cerebro, recordemos que tenemos neuronas y conexiones entre ellas, que almacenan nuestra "información": recuerdos, habilidades, etc. Básicamente, todo lo que nos define. La base de cualquier IA son las redes neuronales artificiales , algo que se escucha todo el tiempo cuando se habla de Deep Learning. Estas redes tratan de imitar la forma en que las neuronas biológicas procesan la información y pueden aprender de enormes cantidades de datos para hacer predicciones más precisas.

La idea de entrenarlas con grandes volúmenes de información es que aprendan a generalizar 📚. Es como cuando de niños aprendemos a comer con cuchara: después de hacerlo con un caldo, podemos aplicarlo al cereal sin que nadie nos lo explique otra vez. Esa capacidad de generalización permite que las redes neuronales artificiales sean adaptables a nueva información y útiles en diferentes contextos.

Otro ejemplo sería cómo nosotros identificamos si un animal es un perro 🐕 o un gato 🐱. Si queremos enseñarle esto a una máquina, con Deep Learning la red neuronal analizaría millones de imágenes y aprendería por sí misma a identificar patrones: orejas puntiagudas, bigotes, ojos grandes, etc. Con el tiempo, podrá reconocer un gato en una foto nueva sin que nadie se lo diga explícitamente. Es un proceso muy parecido al que usamos los humanos para aprender.

Es muy sencillo explicar el Deep Learning de esta manera; sin embargo, está lleno de muchas complejidades matemáticas y computacionales 🔢. A lo largo de mi tiempo trabajando con modelos, he podido observar aquellos más sencillos que predicen valores fáciles como peso, estatura o la detección de algún objeto o animal. Otros tratan de buscar algún tipo de relación o estructura en datos para crear grupos. También están los modelos generativos 🎨 (los más recientes y generalmente difíciles de comprender a la primera), que suelen ser los más complejos debido a que, por lo general, son ensambles de otros modelos y arquitecturas de redes diferentes, cada una con tareas específicas dentro del modelo de red, además de ser los más pesados computacionalmente, ya que trabajan con datos no estructurados, como texto ✍️, imágenes 🖼️, audio 🎵 y video 🎬.

¿Cómo funciona el Deep Learning?

No entraré en detalles acerca de los aspectos matemáticos , solo te platicaré un poco de su funcionamiento y aquellas arquitecturas más usadas, y si es que alguna vez te cruzas con alguna de ellas, sabrás un poco de su funcionamiento y por qué tiene lo que tiene.

🧠 Las redes neuronales artificiales normalmente se tratan de organizar en capas:

- Capa de entrada: 📥 Recibe la información (una imagen, un texto, una señal de audio, etc.).

- Capas ocultas: 🔄 Procesan la información, identificando patrones y relaciones complejas.

- Capa de salida: 📤 Genera un resultado, como decir "esto es un gato" o, como en GPT, genera texto.

Cada capa y módulo de la arquitectura de la red refina la información y mejora la precisión del modelo con el objetivo de aprender de los datos de entrada. Lo asombroso es que, al igual que un humano que practica un deporte o aprende un idioma, estas redes mejoran con la experiencia, pero en este caso, la experiencia son los datos.

Así, la red básicamente busca adaptarse y aprender lo mejor posible las relaciones entre los datos para obtener la mejor predicción posible. Si la predicción no es muy buena, la red se penaliza a sí misma, ajustando sus "parámetros" (o información en las neuronas) para mejorar la precisión.

Cuando hablo de ajustar sus parámetros, normalmente una red tiende a tener desde miles hasta billones de parámetros que debe entrenar para mejorar sus resultados, lo que la hace computacionalmente exigente, y estos parámetros no son más que tensores o, de forma coloquial, una especie de matrices multidimensionales.

Los parámetros y los hiperparámetros en una red neuronal son como los ingredientes y las recetas de un platillo. Los parámetros son lo que la red aprende por sí sola mientras entrena, como los pesos y los sesgos, que determinan cómo se procesan los datos. Por otro lado, los hiperparámetros son las decisiones que tomamos antes de entrenar la red, como cuántas capas tendrá, cuántas neuronas en cada capa o qué tan rápido debe aprender (learning rate).

⚙️ Existen varios tipos de hiperparámetros importantes:

- Hiperparámetros de estructura: Como el número de capas y neuronas en cada capa, que determinan el tamaño y la capacidad de la red.

- Hiperparámetros de optimización: ⚡ Como la tasa de aprendizaje (learning rate), que define qué tan rápido o lento se ajustan los parámetros de la red.

- Hiperparámetros de regularización: 🎯 Como dropout y L2, que evitan que la red memorice los datos en lugar de generalizar correctamente.

- Hiperparámetros específicos de arquitecturas avanzadas: 🔧 Como el número de cabezas en modelos de atención (Transformers) o el tamaño de los kernels en redes convolucionales.

Elegir buenos hiperparámetros es clave para que el modelo funcione bien sin desperdiciar recursos computacionales y pueda adaptarse de la mejor manera a los datos.

Algunas arquitecturas de redes más utilizadas

Existen varios tipos de redes neuronales. Aunque constantemente surgen nuevas arquitecturas o combinaciones para tareas específicas, podemos identificar las siguientes arquitecturas "base", cada una con un propósito particular:

- MLP (Perceptrón Multicapa): Es la red más básica, se usa para tareas generales de clasificación y regresión.

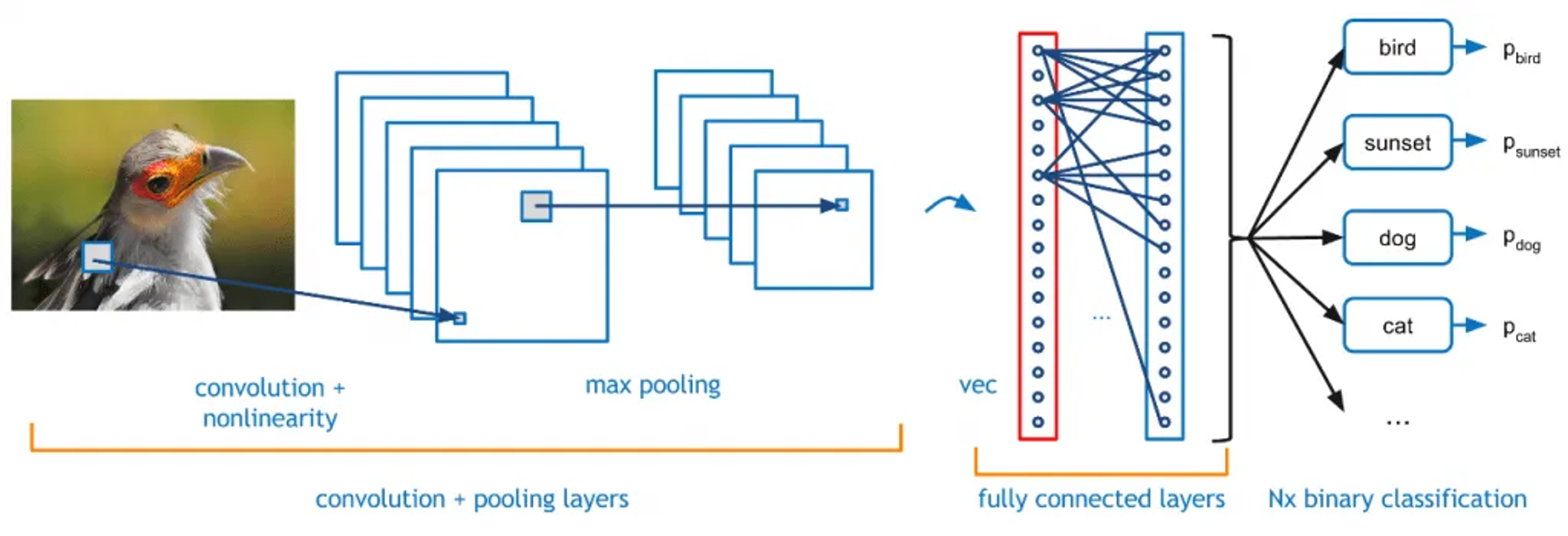

- CNN (Redes Neuronales Convolucionales): Ideales para procesar imágenes, videos y audios. Se usan en reconocimiento facial, análisis de imágenes para deteccion y generacion de imagens.

- RNN (Redes Neuronales Recurrentes): Especializadas en secuencias de datos como texto y audio. Se usan en modelos de lenguaje y predicción de series de tiempo.

- LSTM (Memoria a Largo Corto Plazo): Una mejora de las RNN que maneja mejor secuencias largas sin olvidar información crucial. Se usan en traducción automática y asistentes de voz.

- Autoencoders: Redes que aprenden representaciones comprimidas de los datos, útiles para reducción de dimensionalidad y generación.

- Transformers: Utilizados en modelos de lenguaje como GPT y BERT. Son la base de los asistentes de inteligencia artificial modernos.

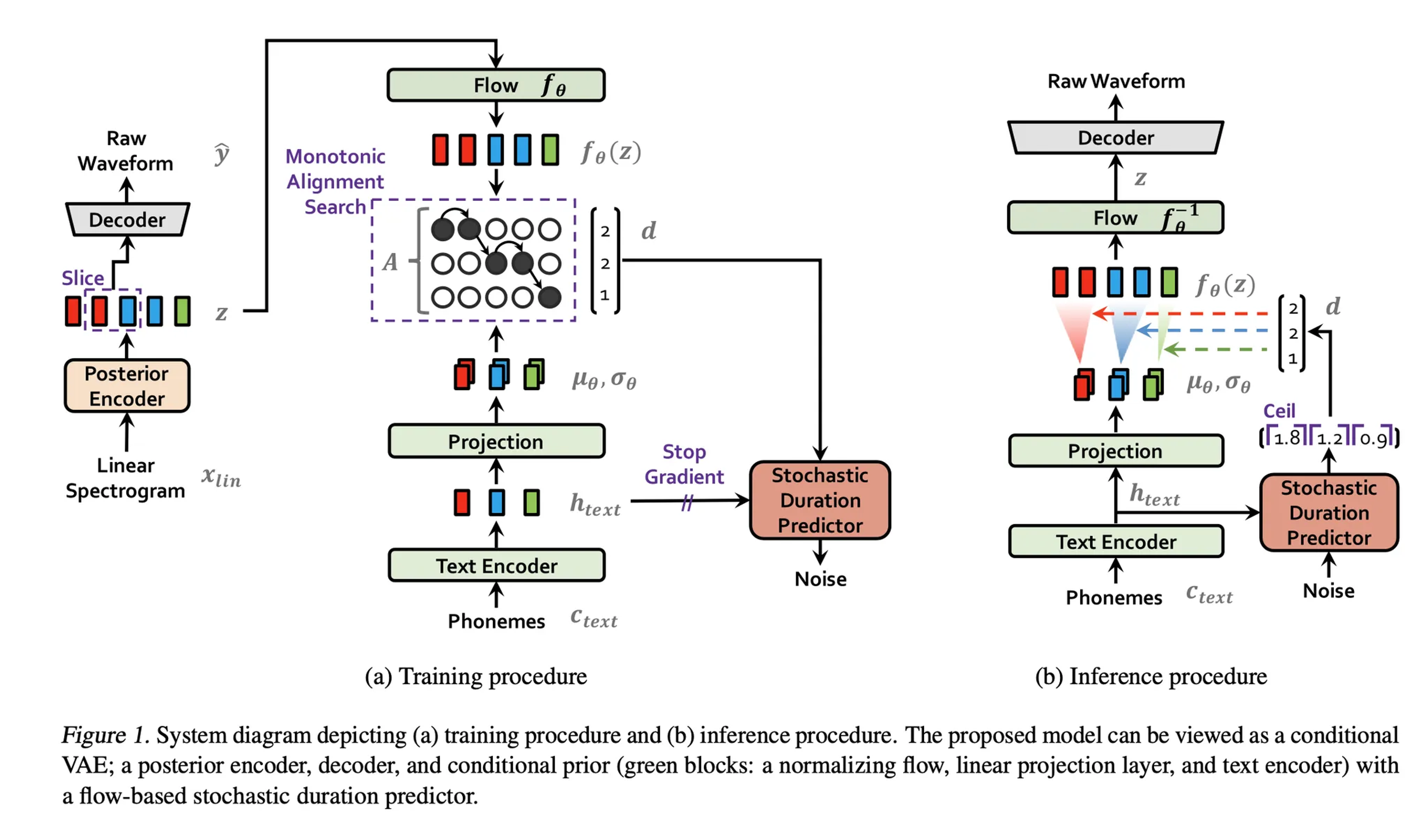

Esquema del modelo VITS-2

Modelo VITS-2 utilizando en uno de los proyectos de SIAFI, para un modelo TTS. Observa que utiliza capas de autoencode, transformer,skip-conections y MLP.

Cada una de estas redes tiene una función específica dentro del mundo de la IA, permitiendo solucionar problemas complejos con mayor precisión y eficiencia. Además, existen otras arquitecturas avanzadas que han revolucionado el campo:

- GANs (Redes Generativas Antagónicas): Se usan para generar imágenes, música, y hasta texto sintético. Funcionan con dos redes neuronales que compiten entre sí: una crea contenido y la otra intenta distinguirlo de contenido real.

- Redes de Difusión: Modelos modernos que han mejorado la generación de imágenes y datos al aprender un proceso inverso para transformar ruido aleatorio en imágenes nítidas.

- Capsule Networks (CapsNets): Mejoran el reconocimiento de objetos en imágenes con información sobre la posición y orientación de las partes de un objeto.

- Graph Neural Networks (GNNs): Se usan en problemas donde los datos tienen estructura de grafo, como en redes sociales, biología y recomendaciones personalizadas.

Cada una de estas arquitecturas aporta capacidades específicas y existen muchas mas, sin embargo estas son aquellas arquitecturas mas basicas y usadas en el campo.

Representación red convolucional

Representraacion de una arquitectrua de Red Convolucional para clasificacion mediante imagenes. Fuente: https://www.lisdatasolutions.com/es/blog/deep-learning-clasificando-imagenes-con-redes-neuronales/

¿Por qué el Deep Learning está revolucionando la IA?

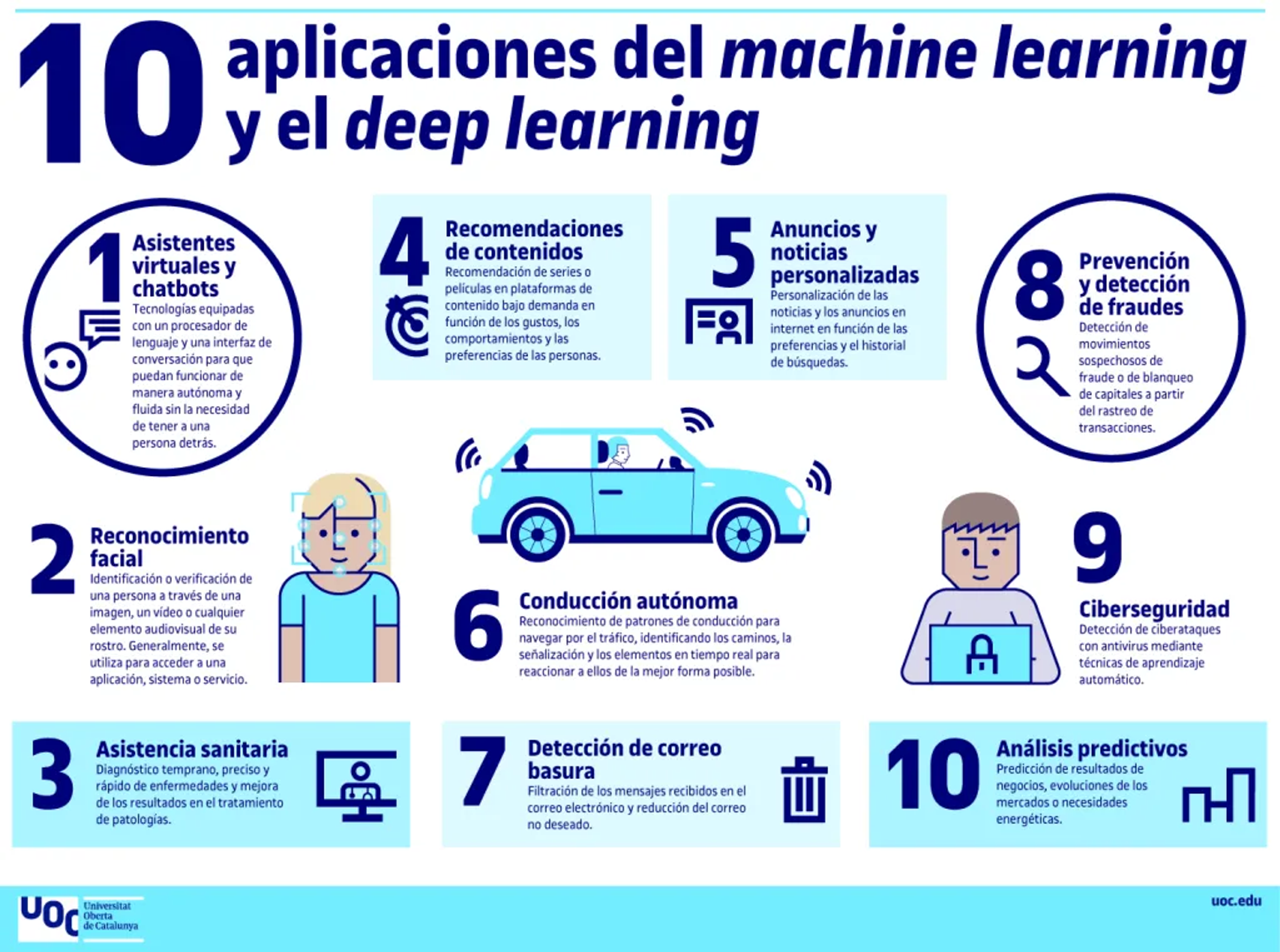

Aplicaciones deep learning

Ejemplo de las aplicaciones cotidianas del deep learning. Fuente: https://blogs.uoc.edu/informatica/es/machine-learning-vs-deep-learning-diferencias/

El Deep Learning es como el "superpoder" de la inteligencia artificial. Ha permitido que las máquinas no solo sigan instrucciones preprogramadas, sino que realmente "aprendan" de los datos y mejoren con la experiencia. No se trata solo de hacer cálculos más rápidos, sino de comprender patrones, hacer predicciones e incluso generar contenido de manera sorprendente. 🚀

Imagínalo así: antes, las computadoras eran como chefs 👩🍳 que solo podían seguir recetas exactas. Ahora, con Deep Learning, son capaces de probar ingredientes, ajustar sabores y crear nuevas recetas por sí mismas. Es por esto que vemos asistentes virtuales cada vez más precisos 🤖, traductores automáticos más naturales 🌍 y hasta inteligencias que pueden pintar cuadros 🎨 o componer música 🎵.

Gracias al Deep Learning, la IA está dejando de ser algo exclusivo de películas de ciencia ficción y se está convirtiendo en una herramienta cotidiana que mejora nuestra calidad de vida. Ya sea ayudando a médicos a diagnosticar enfermedades con mayor precisión 🎯, permitiendo que autos autónomos circulen con seguridad , o incluso impulsando la creatividad en el mundo del arte y la música , este avance está cambiando el mundo de formas que antes parecían imposibles.

El Deep Learning ha impulsado la IA hasta niveles que hace unos años parecían ciencia ficción. Algunas de sus aplicaciones incluyen:

- Reconocimiento de voz y texto: Siri, Google Assistant y Alexa entienden lo que decimos gracias a redes neuronales entrenadas para interpretar el lenguaje humano.

- Visión por computadora: Los autos autónomos usan Deep Learning para reconocer objetos, peatones y señales de tráfico en tiempo real.

- Medicina: Algoritmos pueden analizar radiografías y detectar enfermedades con mayor precisión que los médicos.

- Entretenimiento y creación de contenido: Plataformas como TikTok, Netflix y Spotify usan Deep Learning para recomendar contenido adaptado a nuestros gustos.

El futuro del Deep Learning

A medida que las computadoras se vuelven más potentes y los datos se acumulan en cantidades gigantescas, el Deep Learning seguirá evolucionando. Podría ayudar a resolver problemas complejos como el cambio climático, la energía renovable y la automatización de tareas peligrosas.

Si bien la IA no sustituirá a los humanos en todo, su capacidad de aprender y mejorar seguirá impactando nuestras vidas. Entender el Deep Learning nos ayuda a comprender cómo las máquinas "piensan" y cómo podemos aprovechar su poder para mejorar el mundo.

🚀 ¡El futuro ya está aquí y el Deep Learning es el motor que lo impulsa! 🤖✨